8. Revisão por Pares Aberta, Métricas e Avaliação

O que é?

Ser investigador é estar num processo de constante avaliação. O mundo académico é uma “economia do prestígio” em que o valor de um investigador é aferido através da atenção que as suas publicações obtêm por parte dos seus pares, decisores políticos e outros. (Blackmore and Kandiko, 2011). Nesta secção é importante clarificar a diferença entre a avaliação de um resultado de investigação e a avaliação do próprio investigador. Tanto os resultados da investigação como os investigadores são avaliados mediante dois métodos essenciais: revisão por pares e métricas, a primeira qualitativa e as segundas quantitativas.

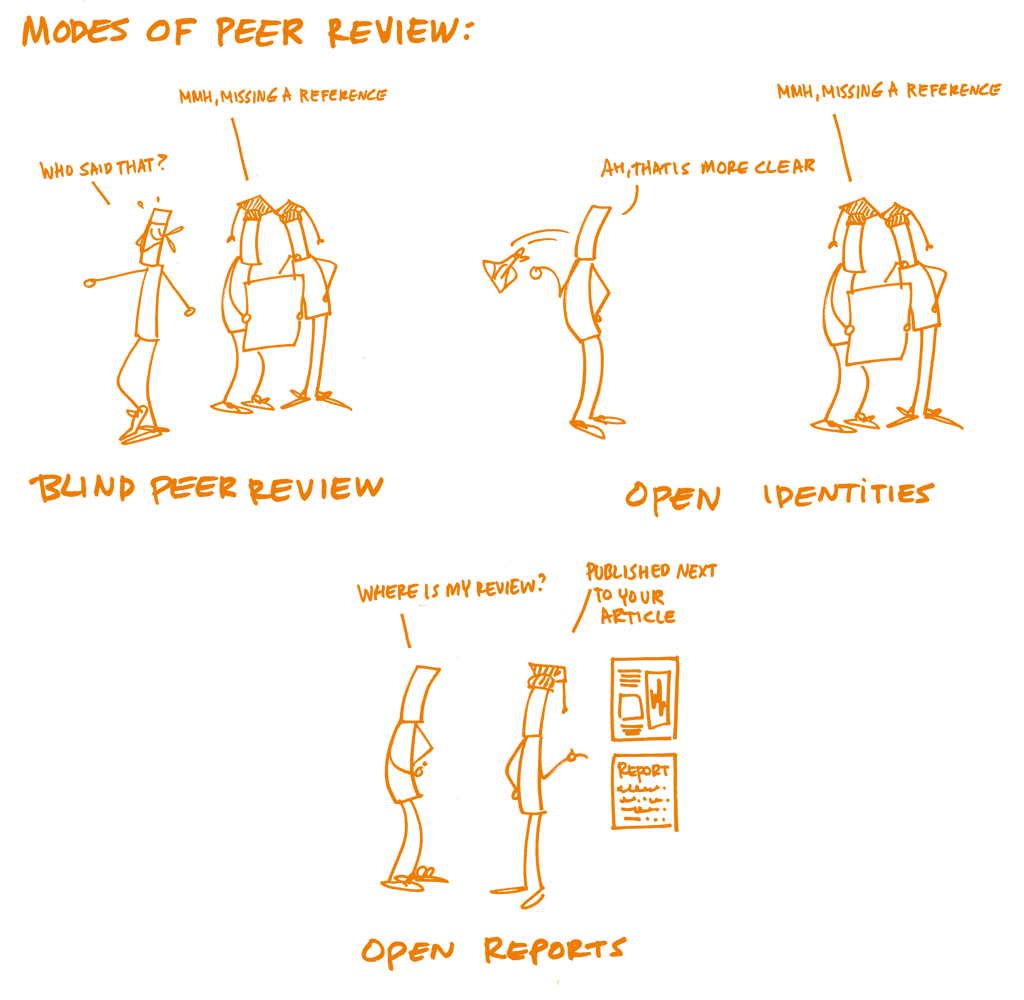

A revisão por pares é usada para avaliar o conteúdo dos resultados de investigação. Trata-se do mecanismo formal de certificação da qualidade através do qual os manuscritos (por exemplo artigos de revistas, livros, candidaturas a bolsas de financiamento, e comunicações a conferências) são sujeitos ao escrutínio de outros, cujos comentários e feedback em geral são utilizados para melhorá-los e tomar decisões sobre a seleção (para publicação, alocação de bolsas de financiamento ou de tempo para falar). A revisão por pares aberta assume significados diferentes para diferentes pessoas e comunidades, tendo sido definida como “termo abrangente para um conjunto de formas diferentes e sobrepostas em que os modelos da revisão por pares podem ser adaptados em função dos objetivos da Ciência Aberta.” (Ross-Hellauer, 2017).

As duas principais características são as “identidades abertas” em que os nomes do autor e do revisor são conhecidos por ambos (isto é, não se trata de revisão cega) e “comentários abertos” em que os comentários dos revisores são publicados juntamente com o artigo. Estas práticas podem ainda ser complementadas, ou não, por outras como a “participação aberta”, na qual os membros da comunidade em geral podem contribuir para o processo de revisão, “interação aberta”, onde a discussão entre autores e revisores, e / ou entre diferentes revisores, é permitida e encorajada, e os “preprints”, em que os manuscritos são disponibilizados online antes de qualquer procedimento formal de revisão por pares (como parte do workflow de revistas científicas ou em repositórios de preprints).

Após o processo de revisão por pares, as publicações são muitas vezes o principal meio de avaliação do trabalho de um investigador (daí a expressão "publicar ou perecer”). No entanto, avaliar a qualidade das publicações é difícil e subjetivo. Embora atualmente algumas metodologias de avaliação como a do UK Research Excellence Framework levem em consideração a revisão por pares, a avaliação de investigadores é globalmente baseada em métricas como o número de citações das publicações (h-index), ou em indicadores de prestígio da revista em que o artigo foi publicado (quantificados pelo Journal Impact Factor). O uso exclusivo destas métricas e a maneira como elas podem distorcer a avaliação tem sido enfatizado nos últimos anos por meio de declarações como o Leiden Manifesto e o San Francisco Declaration on Research Assessment (DORA).

Recentemente as "Métricas Alternativas" ou altmetrics ganharam relevância no debate sobre uma avaliação equilibrada dos esforços de investigação que complementam a contagem de citações, contabilizando outras medidas on-line do impacto, incluindo marcadores, links, referência em blogs, tweets, likes, compartilhamentos, cobertura da imprensa e afins. Um dos aspetos críticos associados à avaliação é o facto de as métricas "tradicionais" serem produzidas e disponibilizadas por empresas (por exemplo Clarivate Analytics e Elsevier) em sistemas proprietários, o que pode colocar problemas relativos à transparência dos dados.

Fundamentação

Revisão por pares aberta

Tendo iniciada no século 17 com a Royal Society of London (1662) e a Académie Royale des Sciences de Paris (1699), como forma de a ciência se censurar a si própria ao invés de ser censurada pela igreja, levou muitos anos até a revisão por pares se estabelecer devidamente na ciência. Como procedimento formal, é muto mais recente do que se poderá assumir. Por exemplo, a revista Nature apenas introduziu a revisão por pares em 1967. Estudos demonstram que, em geral, os investigadores valorizam a revisão por pares, embora considerem que poderia funcionar melhor. Algumas das críticas em relação à revisão por pares é que demora muito, é inconsistente e muitas vezes não deteta os erros, e que o anonimato pode proteger enviesamentos dos revisores . A revisão por pares aberta visa, portanto, trazer maior transparência e participação aos processos de revisão por pares formais e informais. Ser um revisor oferece aos investigadores a oportunidade de envolverem com novidades na investigação, construir redes de investigação e especialidades, e melhorar as suas próprias competências de escrita. É um elemento fundamental no controlo da qualidade do trabalho científico. No entanto, em geral, os investigadores não recebem qualquer tipo de formação sobre como fazer a revisão por pares. Mesmo quando os investigadores sentem confiança na revisão por pares tradicional, a revisão por pares aberta, nas suas múltiplas formas, apresenta novos desafios e oportunidades. Uma vez que a revisão por pares aberta cobre uma grande diversidade de práticas, são muitas as questões a ter em conta por parte de autores e revisores.

No que respeita à avaliação da investigação, as recompensas e métricas atuais não estão (ainda) alinhadas com os pressupostos da Ciência Aberta. As métricas utilizadas para avaliar investigação (por exemplo, o Journal Impact Factor, o h-índice) não medem – e por essa razão não premeiam – as práticas de Ciência Aberta. A revisão por pares aberta não é muitas vezes reconhecida como atividade de caráter académico e científico em contextos de avaliação para progressão na carreira (em muitos casos os avaliadores de pedidos de financiamento não consideram sequer as mais brilhantes revisões abertas como outputs académicos em si mesmos). Adicionalmente, muitas métricas de avaliação , em especial algumas bibliométricas, não são tão abertas e transparentes como a comunidade desejaria. Nestas circunstâncias, na melhor das hipóteses, as práticas de Ciência Aberta são vistas como uma carga adicional sem recompensas evidentes ou vantagens concretas. Na pior, são consideradas passíveis de prejudicar futuro financiamento e promoção, bem como agregação. Um relatório recente da Comissão Europeia (2017) identifica duas abordagens na implementação da Ciência Aberta e na forma como os métodos de avaliação podem auxiliar:

Manter os métodos atuais de avaliação, encorajando práticas mais abertas em relação às métricas e aos resultados de investigação;

Implementar métodos de avaliação com recurso a métricas alternativas, dados abertos, ciência cidadã e aprendizagem aberta.

Cada vez mais financiadores e instituições estão a caminhar nesta direção, por exemplo, afastando-se das contagens e incluindo indicadores de impacto social nos processos de avaliação. Outros passos que as entidades financiadoras estão a implementar são permitir que sejam inluídos mais tipos de resultados de investigação (como preprints) nas candidaturas e financiar diferentes tipos de investigação (como estudos de replicabilidade).

Objetivos de aprendizagem

- Reconhecer os principais elementos da revisão por pares aberta e suas potenciais vantagens e desvantagens;

- Compreender as diferenças entre tipos de métricas usadas para avaliar investigação e investigadores;

- Envolver-se no debate sobre a maneira como as regras de avaliação afetam a forma como a investigação é conduzida.

Componentes-chave

Conhecimento

Revisão por pares aberta

As práticas de revisão por pares aberta são realidade em revistas científicas publicadas por editores como Copernicus, Frontiers, BioMed Central, eLife e F1000research. A revisão por pares aberta, nas suas diferentes formas, apresenta muitas potenciais vantagens para autores e revisores:

Revisão com “Identidades abertas” (o oposto da revisão cega) fomenta uma maior responsabilidade dos revisores e reduz as possibilidades de vieses ou conflitos de interesse não revelados.

Os relatórios de revisão abertos adicionam uma garantia de qualidade, permitindo que a comunidade em geral analise as revisões e os processos de tomada de decisão.

Combinados, as identidades abertas e os relatórios de revisão abertos contribuem para aumentar a qualidade das revisões, pois o facto de ter o seu nome publicamente associado a um trabalho científico ou de ver a sua revisão publicada incentiva os revisores a serem mais minuciosos.

As identidades abertas e os relatórios de revisão abertos permitem que os revisores sejam reconhecidos publicamente pelo seu trabalho de revisão, incentivando esta atividade essencial e permitindo que o trabalho de revisão seja citado noutras publicações e em atividades ligadas à progressão na carreira e agregação.

A participação aberta pode superar problemas associados à seleção editorial de revisores (por exemplo, preconceitos, redes fechadas, elitismo). Especialmente para investigadores em início de carreira que ainda não receberam convites para revisão, esses processos abertos também podem apresentar oportunidades para construir a sua reputação científica e desenvolver competências de revisão.

Existem alguns riscos potenciais, a saber:

As identidades abertas retiram o anonimato aos revisores (single-blind) ou aos autores e revisores (double-blind), que tradicionalmente existiam para evitar vieses sociais (embora não haja evidências claras de que tal anonimato tenha sido eficaz). Assim, é importante que os revisores garantam que as revisões refletem apenas a qualidade científica do manuscrito, e não questões ligadas ao estatuto, currículo ou afiliação dos autores. Os autores devem assumir a mesma postura ao receber os comentários da revisão por pares.

Dar e receber críticas é muitas vezes um processo caracterizado por reações emocionais inevitáveis - autores e revisores podem concordar ou discordar subjetivamente sobre como apresentar os resultados e / ou o que precisa ser melhorado, acrescentado ou corrigido. Com as identidades e comentários abertos, estas divergências podem ser exacerbadas. Por esta razão, é fundamental que os revisores comuniquem os seus pontos de vista de uma forma civilizada e clara, de forma a garantir que estes são bem recebidos pelos autores.

A supressão do anonimato nas identidades abertas pode subverter o processo, ao desencorajar os revisores a fazer críticas, especialmente em relação a colegas mais prestigiados.

Por fim, considerando estas questões, existe maior probabilidade de os potenciais revisores recusarem fazer a revisão.

Métricas abertas

A Declaração de São Francisco sobre Avaliação de Investigação(DORA) recomenda que se evitem as metodologias de avaliação baseadas em indicadores de prestígio de revistas científicas, que passem a considerar-se todos os tipos de resultados de investigação e a usar-se em paralelo várias formas de métricas e métodos de avaliação qualitativa Esta declaração foi assinada por milhares de investigadores, instituições, editores e financiadores, que se comprometem a colocar estes princípios em prática. O Manifesto de Leiden fornece orientações para um uso responsável das métricas.

Segundo Priem et al. (2010) as métricas alternativas apresentam as seguintes vantagens: são obtidas mais rapidamente que as citações; medem o impacto de resultados de investigação para além dos artigos científicos (por exemplo, conjuntos de dados, código, protocolos, posts de blogues, tweets, etc.); e podem fornecer diferentes medidas de impacto por artigo ou item. A celeridade das métricas alternativas apresenta vantagens particularmente para os investigadores em início de carreira, cujo impacto da investigação pode ainda não estar refletido em citações, mas cuja progressão na carreira está muito dependente de boas avaliações. Adicionalmente, as métricas alternativas podem ajudar na identificação precoce de áreas de investigação importantes e de potenciais colaborações entre investigadores. Um relatório recente do Grupo de Especialistas em Altmetria da Comissão Europeia (Direcção-Geral de Investigação e Inovação, 2017) identificou os desafios das métricas alternativas, tais como a falta de robustez e susceptibilidade à manipulação; que quando um indicador ou métrica se torna o objetivo, deixa de ser bom indicador ("Lei de Goodhart"); a falta de uso corrente de redes sociais em algumas áreas científicas ou regiões geográficas; e A dependência de empresas para recolha dos dados primários.

Competências

Exercícios

Os formandos trabalham em grupos de três. Cada um individualmente faz uma revisão de um texto académico curto

Elaborar a revisão de um paper disponível num repositório de preprints

Usar um serviço gratuito de bibliometria ou de métricas alternativas\ (por exemplo, Impactstory, Paperbuzz, Altmetric bookmarklet, Dimensions.ai ) para procurar métricas para um artigo e, em seguida, escreva uma breve explicação de como as várias métricas recolhidas por cada serviço são calculadas \ (é mais difícil do que parece; implica a localização de documentação sobre as métricas recolhidas, mesmo nas plataformas que funcionam de forma mais transparente )

Perguntas, obstáculos e equívocos comuns

Q: A avaliação da investigação é justa?

A: A avaliação da investigação é tão justa quanto seus métodos e técnicas. As métricas tradicionais e alternativas tentam aferir a qualidade da investigação com base na quantidade, o que pode não ser necessariamente correto.

Resultados da aprendizagem

- Os formandos serão capazes de identificar revistas com revisão por pares aberta.

- Os formandos conhecerão uma maior variedade de métricas, suas vantagens e desvantagens.

Leitura adicional

Directorate-General for Research and Innovation (European Commission) (2017). Evaluation of Research Careers Fully Acknowledging Open Science Practices: Rewards, Incentives and/or Recognition for Researchers Practicing Open Science. doi.org/10.2777/75255

Hicks et al. (2015) Bibliometrics: The Leiden Manifesto for research metrics. doi.org/10.1038/520429a, leidenmanifesto.org

Peer Review the Nuts and Bolts (2012). A Guide for Early Career Researchers. PDF

Iniciativas e projetos

Make Data Count. makedatacount.org

NISO Alternative Assessment Metrics (Altmetrics) Initiative. niso.org

Open Rev. openrev.org

OpenUP Hub. openuphub.eu

Peer Reviewers’ Openness Initiative. opennessinitiative.org

Peerage of Science. A free service for scientific peer review and publishing. peerageofscience.org

Responsible Metrics. responsiblemetrics.org

Snowball Metrics. Standardized research metrics - by the sector for the sector. snowballmetrics.com