8. Revisione tra pari aperta, metriche e valutazione

Di che cosa si tratta?

Essere un ricercatore significa trovarsi continuamente sotto giudizio degli altri. L’Accademia è “un’economia del prestigio” in cui il valore degli accademici è basato sulle valutazioni circa il livello di stima di cui godono loro stessi e i loro contributi presso i pari, i decisori e altri (Blackmore and Kandiko, 2011). In questa sezione sarà quindi opportuno distinguere tra la valutazione di un lavoro di ricerca e la valutazione del ricercatore. Sia la ricerca, sia il ricercatore sono sottoposti a valutazione attraverso due metodi principali: la revisione tra pari (peer review) e le metriche, il primo qualitativo e il secondo quantitativo.

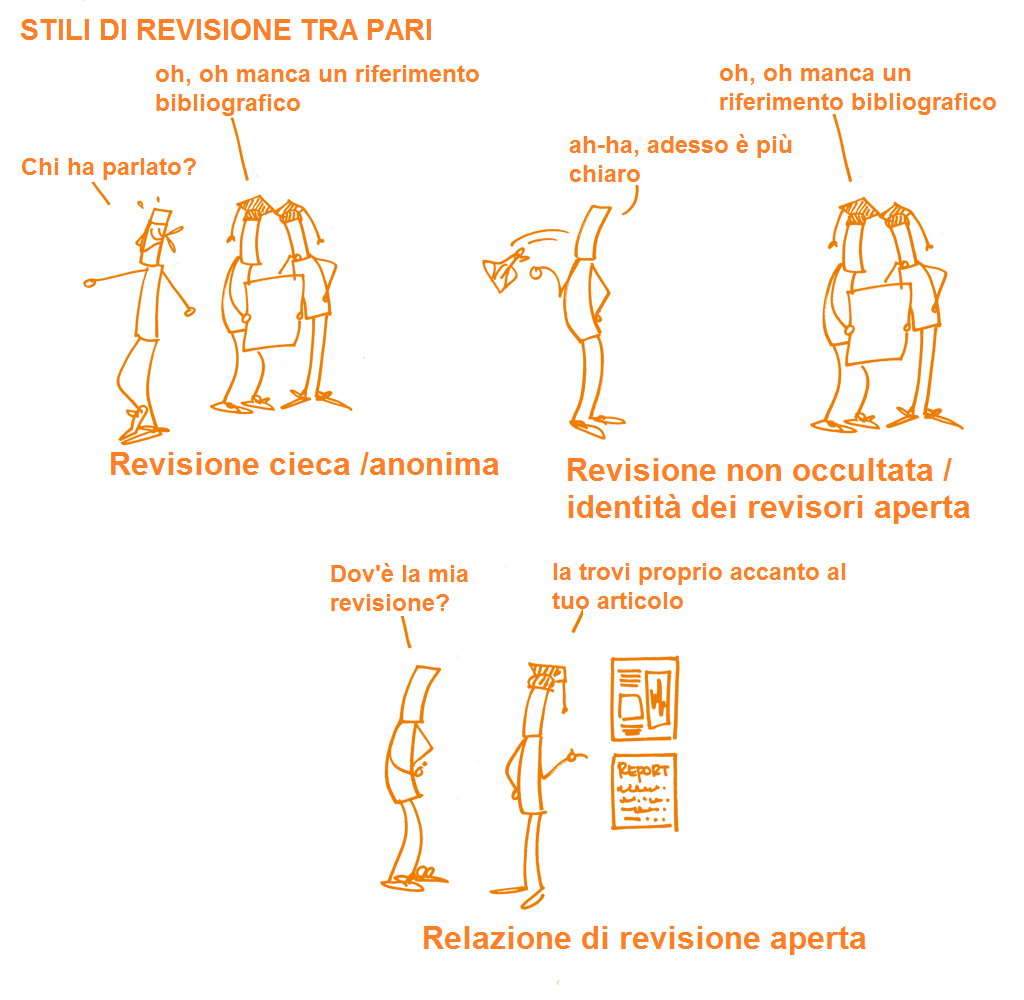

La revisione tra pari è usata, in primo luogo, per valutare l’appropriatezza dei prodotti della ricerca. È il meccanismo formale di garanzia di qualità per il quale i manoscritti scientifici (per esempio, articoli su riviste, libri, progetti per finanziamenti e contributi in convegni) vengono sottoposti allo scrutinio di altri, i cui commenti e giudizi sono poi usati per migliorare i lavori e prendere la decisione finale sulla loro accettazione (per la pubblicazione, la concessione del finanziamento o l’inserimento nel programma di un convegno). La revisione tra pari aperta (Open Peer Review) ha un significato diverso per persone e comunità differenti ed è stata definita come “termine generico per indicare una serie di modalità similari in cui i modelli di peer review possono essere adattati in accordo con gli obiettivi della Scienza Aperta” (Ross-Hellauer, 2017). I tratti peculiari della revisione tra pari aperta sono le “identità aperte”: autori e revisori conoscono le rispettive reciproche identità (referaggio non alla cieca dall’inglese ‘non blinded’) e la “relazione di referaggio aperta” per cui si prevedere che i risultati della peer review vengano pubblicati insieme al corrispondente articolo. Queste caratteristiche possono ma non devono essere necessariamente combinate; possono altresì essere integrate con altre pratiche innovative come la “partecipazione aperta” che prevede che tutti i membri dell’intera comunità scientifica possano contribuire al processo di revisione; l’“interazione aperta” che consente ed incoraggia una discussione bi-direzionale tra autori e revisori e/o tra revisori; “l’anteprima aperta del manoscritto” in cui i manoscritti vengono resi immediatamente disponibili prima di qualsiasi processo formale di referaggio (sia internamente come parte del flusso di lavoro della rivista sia esternamente attraverso gli archivi preprint).

Una volta passate attraverso il processo di revisione aperta tra pari, le pubblicazioni scientifiche diventano poi spesso la prima forma di misurazione del lavoro di un ricercatore (da qui il modo di dire "o si pubblica o si muore"(dall'inglese: "publish or perish"). Tuttavia, giudicare la qualità di una pubblicazione è difficile e soggettivo. Nonostante alcuni esercizi di valutazione generici come il Research Excellence Framework (Regno Unito) utilizzino la revisione aperta tra pari, la valutazione si basa spesso sulle metriche, come ad esempio, il numero delle citazioni (h-index), o anche il livello di influenza percepito della rivista dove si è pubblicato (espresso dal suo fattore di impatto). L’uso predominante di tali metriche e il modo in cui queste possono alterare l'attribuzione degli incentivi sono stati messi in evidenza in alcune dichiarazioni come il Manifesto di Leiden e la Declaration on Research Assessment (DORA) di San Francisco.

Negli ultimi anni si è cominciato a discutere sulle cosiddette metriche alternative o “altmetrics” contestualmente al dibattito su come misurare adeguatamente i risultati della ricerca attraverso l’integrazione -nel conteggio delle citazioni- di altri strumenti online per misurare l’impatto della ricerca, come i salvataggi nei bookmark, i link, i post nei blog, i tweet, i "like", le condivisioni, la visibilità sugli organi di stampa e similari. Tutte le problematiche relative alle metriche sono riconducibili al fatto che a produrle sono entità commerciali (ad esempio, Clarivate Analytics ed Elsevier) che, basandosi su sistemi proprietari, possono creare problemi di trasparenza.

Fondamentali

La revisione tra pari aperta

Introdotta nel XVII secolo dalla Royal Society di Londra (1662) e dall’Académie Royale des Sciences di Parigi (1699) come privilegio del mondo scientifico all'auto-censura anzicchè per volere della Chiesa, ci sono voluti molti anni prima che la revisione tra pari si affermasse adeguatamente. La revisione tra pari, come meccanismo formale, è molto più recente di quanto si possa pensare. La rivista “Nature”, ad esempio, l’ha introdotta solo nel 1967. Sebbene, secondo alcuni studi, i ricercatori sembrino apprezzare la revisione tra pari, risulta altresì che siano dell’opinione che potrebbe funzionare anche meglio. Ci sono spesso lamentele sui tempi troppo lunghi di revisione, sulla sua incongruenza nonché a volte di inefficacia nel riconoscere gli errori e sull’anonimato che può celare parzialità. La revisione tra pari aperta (OPR Open peer review) mira pertanto ad apportare maggiore trasparenza e partecipazione al processo formale ed informale della revisione tra pari. Diventare un revisore offre al ricercatore l’opportunità di essere coinvolto in ricerche innovative, di costruire reti e competenze accademiche e di raffinare le proprie abilità di scrittura. È un elemento cruciale per il controllo della qualità del lavoro accademico. Generalmente, però, i ricercatori non ricevono spesso una preparazione formale su come fare una revisione. Anche laddove i ricercatori si sentano sicuri con la revisione tra pari tradizionale, le molte forme di revisione tra pari aperta presentano, tuttavia, nuove sfide e nuove opportunità. Poiché la OPR copre un’ampia varietà di pratiche, ci sono molte considerazioni di cui i revisori e gli autori devono tenere conto.

Riguardo alla valutazione, attualmente i riconoscimenti e le metriche nella scienza e nelle attività di ricerca non sono (ancora) in linea con la Scienza Aperta. Le metriche usate per valutare la ricerca (ad esempio il fattore di impatto di una rivista scientifica h-index) non misurano - e di conseguenza non premiano - le pratiche di ricerca aperta. L’attività di revisione tra pari aperta non è sempre riconosciuta come “attività scientifica” relativamente alle progressioni di carriera (ad esempio, in molti casi, gli esperti che valutano i progetti di finanziamento non considerano nemmeno le revisioni tra pari aperte più brillanti come degli oggetti scientifici di per sé). Inoltre, molte metriche di valutazione - specialmente certe tipologie di indici bibliometrici - non sono così aperti e trasparenti come la comunità scientifica auspicherebbe.

In questo contesto e, nella migliore delle ipotesi, praticare la Scienza Aperta è percepito come un’altra incombenza fine a sè stessa, senza alcun riconoscimento. Nella peggiore delle ipotesi, è considerato un danno e un ostacolo per accedere a possibili finanziamenti futuri e a promozioni per non parlare di avanzamenti di carriera. Un recente Rapporto della Commissione Europea (2017) ha riconosciuto che ci sono fondamentalmente due approcci all’implementazione della Scienza Aperta e al modo in cui i riconoscimenti e la valutazione possono favorirla:

Sostegno puro e semplice dell’attuale stato dell’arte incoraggiando maggiore apertura, costruendo metriche adatte e quantificando i prodotti;

Sperimentazione di pratiche alternative di ricerca e valutazione, dati aperti, scienza partecipativa e risorse di insegnamento e apprendimento aperte.

Enti finanziatori ed istituzioni si stanno muovendo sempre di più verso queste due direzioni, prendendo distanza, ad esempio, dai semplici conteggi numerici e includendo nei loro esercizi di valutazione resoconti e indicazioni sull’impatto sociale. Altri passi che gli enti finanziatori stanno compiendo sono l’inclusione nei bandi di altri tipi di prodotti della ricerca (come i manoscritti non referati) e il finanziamento di diverse tipologie di studi di ricerca (come gli studi sulla replicazione).

Finalità didattiche:

- Riconoscere gli elementi chiave della revisione aperta tra pari e i potenziali vantaggi e svantaggi.

- Comprendere le differenze tra le diverse tipologie di metriche usate per valutare la ricerca e i ricercatori.

- Partecipare al dibattito su come il modello di valutazione influenzi la maniera nella quale si fa ricerca.

Componenti chiave

Conoscenza

Revisione tra pari aperta

Sedi popolari per la revisione tra pari aperta, includono riviste scientifiche di editori, come Copernicus, Frontiers, BioMed Central, eLife e F1000research.

La revisione tra pari aperta, in tutte le sue diverse forme, ha molti potenziali vantaggi per revisori e autori:

La revisione con identità aperte (non-cieca) favorisce una maggiore affidabilità tra i revisori e riduce le occasioni di parzialità e di conflitti di interesse non dichiarati.

Le relazioni di referaggio aperte aggiungono un altro livello di garanzia di qualità, permettendo alla comunità scientifica estesa di verificare le revisioni e analizzare il processo decisionale.

Si è teorizzato che, se combinate, le identità aperte e le relazioni di referaggio aperte portano a revisioni qualitativamente migliori, in quanto il fatto di avere il proprio nome associato pubblicamente ad un lavoro o di vedere la propria revisione pubblicata incoraggia i revisori ad una maggiore accuratezza.

Le identità aperte e le relazioni di referaggio aperte consentono ai revisori di accrescere la reputazione pubblica del loro lavoro di revisione, incentivando in questo modo questa attività essenziale e facendo in modo che il lavoro di revisione venga citato in altre pubblicazioni e tra le attività utili all’avanzamento di carriera legate alla promozione e al ruolo.

La partecipazione aperta potrebbe contribuire a superare i problemi associati alla selezione editoriale dei revisori (per esempio, pregiudizi, reti chiuse, elitarismo). In special modo per i ricercatori che all’inizio della loro carriera non vengono invitati a fare revisioni, questi processi aperti potrebbero rappresentare un’opportunità per costruire la loro reputazione nel mondo della ricerca e acquisire pratica esercitando nuove competenze.

Potenziali trappole da tenere in considerazione:

Le identità aperte rimuovono la condizione di anonimato per i revisori (singola cieca, single-blind) o tra gli autori e i revisori (doppia cieca, double-blind) che tradizionalmente sono state introdotte per contrastare pregiudizi sociali (sebbene l’efficacia dell’anonimato non sia stata provata). È quindi importante che i revisori facciano attenta autocritica sulle proprie conclusioni per essere certi che i loro giudizi riflettano la qualità del manoscritto soltanto non lo stato, la storia o le affiliazioni dell’autore o degli autori. Gli autori dovrebbero fare lo stesso quando ricevono i commenti della revisione da parte dei loro pari.

Fare e ricevere critiche è spesso un processo carico di inevitabili reazioni emotive - gli autori e i revisori potrebbero soggettivamente concordare oppure essere in disaccordo su come presentare i risultati e/o su cosa necessiti di miglioramento, rettifica o correzione. Nelle identità aperte e/o nelle relazioni aperte, la trasparenza potrebbe esacerbare tali difficoltà. È quindi essenziale che i revisori assicurino di comunicare le loro osservazioni in modo chiaro e civile, così da massimizzare le possibilità che vengano accolte come opinioni fondate da parte dell’autore o degli autori.

L’assenza di anonimato per i revisori nella revisione con identità aperte potrebbe minare il processo, scoraggiando i revisori dal fare critiche spietate, specialmente ai danni di colleghi con uno status più alto.

Per concludere e, in considerazione dei punti appena messi in luce, la probabilità che potenziali revisori decidano di declinare l’incarico di revisione aumenta.

Le metriche aperte

La San Francisco Declaration on Research Assessment (DORA) raccomanda di discostarsi dalle valutazioni che si basano sulle riviste scientifiche, di prendere in considerazione tutte le tipologie di prodotti della ricerca e di usare diverse forme di metriche e valutazioni narrative parallelamente. DORA è stata firmata da migliaia di ricercatori, istituzioni, editori e enti finanziatori che si sono impegnati a mettere in pratica quanto previsto dalla dichiarazione. Il Manifesto di Leiden fornisce una guida su come usare le metriche in maniera responsabile.

Per quanto riguarda le metriche alternative, Priem et al. (2010) le consigliano per i seguenti vantaggi: raccolgono le citazioni più velocemente; possono misurare l’impatto anche di prodotti della ricerca diversi dalle pubblicazioni su rivista (per esempio, set di dati, codici, protocolli, post nei blog, tweet, ecc.); e possono fornire misure differenziate dell’impatto per singoli oggetti. La tempestività delle metriche alternative presenta un particolare vantaggio per i ricercatori a inizio carriera, per i quali l’impatto della ricerca potrebbe non essere rispecchiato da un numero significativo di citazioni, ma per i quali comunque un avanzamento di carriera dipende dalle valutazioni positive. In aggiunta, le metriche alternative possono aiutare ad identificare una ricerca influente e le potenziali connessioni tra i ricercatori. Un recente rapporto presentato dal Gruppo di esperti in metriche alternative della Commissione Europea (Wilsdon et al. (European Commission), 2017)) ha identificato le criticità delle metriche alternative: la mancanza di robustezza e la suscettibilità al “gioco d’azzardo”; il fatto che qualsiasi misura cessi di essere una buona misura quando diventa un obiettivo (Legge di Goodhard); la relativa mancanza di diffusione nei social media di alcune discipline e aree geografiche; e il doversi affidare ad entità commerciali per i dati di base.

Compentenze

Esercitazioni

Ai partecipanti viene richiesto di lavorare in gruppo, ognuno composto da tre persone. Ogni partecipante scrive una sua personale revisione di un breve testo accademico.

Revisione di un articolo su un server pre-print

Utilizzo di un servizio gratuito di bibliometria o metriche alternative (ad esempio Impactstory, Paperbuzz, Altmetric bookmarklet, Dimensions.ai) per la ricerca delle metriche di un articolo. I partecipanti devono quindi scrivere una breve spiegazione su come vengono esattamente calcolate le diverse metriche presentate da ciascun servizio (è più difficile di quanto si pensi; significa cercare di individuare la documentazione appropriata sulle metriche anche per i servizi apparentemente più trasparenti).

Domande, intoppi ed equivoci comuni

Domanda: La valutazione della ricerca è imparziale?

Risposta: La valutazione della ricerca è imparziale quanto lo sono i suoi metodi e le tecniche di valutazione. Le metriche e le metriche alternative cercano di misurare la qualità della ricerca con la quantità del prodotto della ricerca, che può essere accurata ma non lo è sempre.

Risultati d’apprendimento

- I partecipanti sono in grado di identificare le riviste a revisione tra pari aperta.

- I partecipanti imparano una serie di metriche con i relativi vantaggi e svantaggi.

Letture integrative

Directorate-General for Research and Innovation (European Commission) (2017). Evaluation of Research Careers Fully Acknowledging Open Science Practices: Rewards, Incentives and/or Recognition for Researchers Practicing Open Science. doi.org/10.2777/75255

Hicks et al. (2015) Bibliometrics: The Leiden Manifesto for research metrics. doi.org/10.1038/520429a, leidenmanifesto.org

Peer Review the Nuts and Bolts (2012). A Guide for Early Career Researchers. PDF

Progetti ed iniziative

Make Data Count. makedatacount.org

NISO Alternative Assessment Metrics (Altmetrics) Initiative. niso.org

Open Rev. openrev.org

OpenUP Hub. openuphub.eu

Peer Reviewers’ Openness Initiative. opennessinitiative.org

Peerage of Science. A free service for scientific peer review and publishing. peerageofscience.org

Responsible Metrics. responsiblemetrics.org

Snowball Metrics. Standardized research metrics - by the sector for the sector. snowballmetrics.com